AWS DataSync タスクのログ記録設定手順

このブログシリーズ 「クラウドセキュリティ 実践集」 では、一般的なセキュリティ課題を取り上げ、「なぜ危険なのか?」 というリスクの解説から、「どうやって直すのか?」 という具体的な修復手順(コンソール、AWS CLI、Terraformなど)まで、分かりやすく解説します。

この記事では、AWS DataSync タスクでのログ記録を有効にして、データ転送の監視とトラブルシューティングを強化する方法について解説します。

ポリシーの説明

AWS DataSync は、オンプレミスストレージと AWS ストレージサービス間、または AWS ストレージサービス間でデータを簡単に転送できるマネージドサービスです。大量のデータ移行、定期的なデータ同期、ディザスタリカバリなどの用途で広く利用されています。

DataSync タスクのログ記録を有効にすることで、以下の情報を CloudWatch Logs に記録できます:

- タスクの開始と終了

- 転送されたファイルとオブジェクトの詳細

- エラーと警告メッセージ

- 転送パフォーマンスのメトリクス

- データ検証の結果

修復方法

コンソールでの修復手順

AWS DataSync タスクでログ記録を有効にする手順:

- AWS マネジメントコンソールにログインし、DataSync コンソールに移動します。

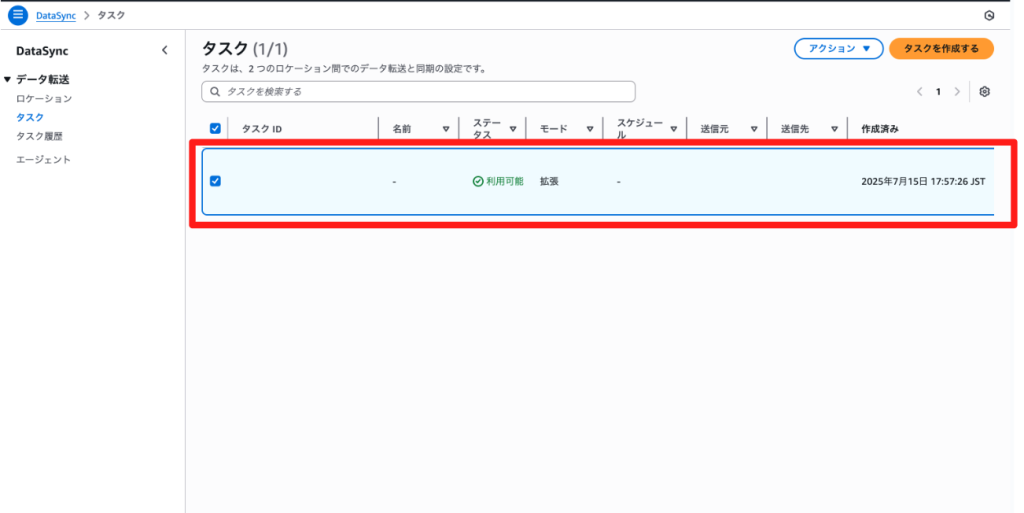

- タスクの選択:

- 左側のナビゲーションペインで「タスク」を選択

- ログ記録を有効にしたいタスクを選択

- タスクの編集:

- タスクの詳細ページで「編集」ボタンをクリック

- 「設定の構成」セクションまでスクロール

- CloudWatch ログ記録の設定:

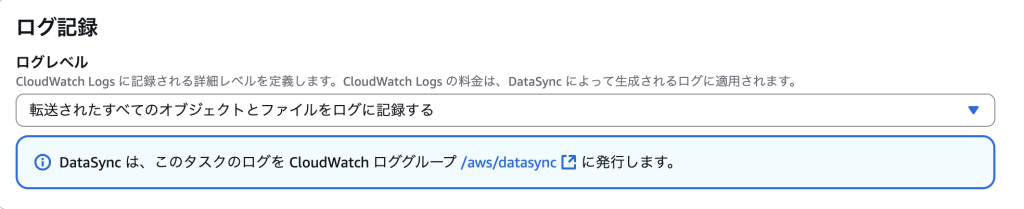

- 「ログ記録」セクションで「有効化」を選択ログレベルを選択:

- ログを生成しない: ログ記録を無効化転送エラーなどの基本情報をログに記録する: 基本的なエラーのみを記録転送されたすべてのオブジェクトとファイルをログに記録する: 転送されたファイルの情報を記録

- 「ログ記録」セクションで「有効化」を選択ログレベルを選択:

- CloudWatch ロググループの設定:

- 既存のロググループを選択または新規作成

- デフォルトでは

/aws/datasyncが使用されます

- 設定の保存:

- すべての設定を確認後、「変更を保存」をクリック

- 既存タスクの更新(オプション):

- 複数のタスクがある場合は、同様の手順で各タスクのログ記録を有効化

Terraformでの修復手順

AWS DataSync タスクのログ記録を有効にする Terraform コード例:

# CloudWatch Log Group の作成

resource "aws_cloudwatch_log_group" "datasync_logs" {

name = "/aws/datasync/task-logs"

retention_in_days = 30

tags = {

Name = "datasync-task-logs"

Environment = var.environment

}

}

# DataSync 用の IAM ロール

resource "aws_iam_role" "datasync_logging" {

name = "DataSyncCloudWatchLogsRole"

assume_role_policy = jsonencode({

Version = "2012-10-17"

Statement = [

{

Action = "sts:AssumeRole"

Effect = "Allow"

Principal = {

Service = "datasync.amazonaws.com"

}

}

]

})

}

# CloudWatch Logs への書き込み権限を持つポリシー

resource "aws_iam_role_policy" "datasync_cloudwatch_logs" {

name = "DataSyncCloudWatchLogsPolicy"

role = aws_iam_role.datasync_logging.id

policy = jsonencode({

Version = "2012-10-17"

Statement = [

{

Effect = "Allow"

Action = [

"logs:CreateLogGroup",

"logs:CreateLogStream",

"logs:PutLogEvents",

"logs:DescribeLogStreams"

]

Resource = [

aws_cloudwatch_log_group.datasync_logs.arn,

"${aws_cloudwatch_log_group.datasync_logs.arn}:*"

]

}

]

})

}

# DataSync ソースロケーション(S3の例)

resource "aws_datasync_location_s3" "source" {

s3_bucket_arn = aws_s3_bucket.source.arn

subdirectory = "/source-data"

s3_config {

bucket_access_role_arn = aws_iam_role.datasync_s3_access.arn

}

tags = {

Name = "datasync-source-location"

}

}

# DataSync デスティネーションロケーション(S3の例)

resource "aws_datasync_location_s3" "destination" {

s3_bucket_arn = aws_s3_bucket.destination.arn

subdirectory = "/destination-data"

s3_config {

bucket_access_role_arn = aws_iam_role.datasync_s3_access.arn

}

tags = {

Name = "datasync-destination-location"

}

}

# DataSync タスク(ログ記録有効)

resource "aws_datasync_task" "main" {

name = "data-sync-task-with-logging"

source_location_arn = aws_datasync_location_s3.source.arn

destination_location_arn = aws_datasync_location_s3.destination.arn

# CloudWatch ログ記録の設定

cloudwatch_log_group_arn = aws_cloudwatch_log_group.datasync_logs.arn

options {

# ログレベルの設定(TRANSFER を推奨)

log_level = "TRANSFER"

verify_mode = "ONLY_FILES_TRANSFERRED"

overwrite_mode = "ALWAYS"

atime = "BEST_EFFORT"

mtime = "PRESERVE"

preserve_deleted_files = "REMOVE"

preserve_devices = "NONE"

security_descriptor_copy = "NONE"

task_queueing = "ENABLED"

}

# データ転送時の帯域幅制限(オプション)

excludes {

filter_type = "SIMPLE_PATTERN"

value = "*.tmp|*.log"

}

tags = {

Name = "datasync-task-with-logging"

Environment = var.environment

}

}

# CloudWatch アラーム(転送エラー監視)

resource "aws_cloudwatch_metric_alarm" "datasync_errors" {

alarm_name = "datasync-transfer-errors"

comparison_operator = "GreaterThanThreshold"

evaluation_periods = "1"

metric_name = "FilesTransferred"

namespace = "AWS/DataSync"

period = "300"

statistic = "Sum"

threshold = "0"

alarm_description = "This metric monitors DataSync transfer errors"

treat_missing_data = "notBreaching"

dimensions = {

TaskArn = aws_datasync_task.main.arn

}

alarm_actions = [aws_sns_topic.alerts.arn]

tags = {

Name = "datasync-error-alarm"

}

}

# ログストリームのメトリクスフィルター(エラー検出)

resource "aws_cloudwatch_log_metric_filter" "datasync_errors" {

name = "datasync-error-count"

log_group_name = aws_cloudwatch_log_group.datasync_logs.name

pattern = "[ERROR]"

metric_transformation {

name = "DataSyncErrorCount"

namespace = "DataSync/Monitoring"

value = "1"

}

}

# S3 バケットアクセス用の IAM ロール(参考)

resource "aws_iam_role" "datasync_s3_access" {

name = "DataSyncS3AccessRole"

assume_role_policy = jsonencode({

Version = "2012-10-17"

Statement = [

{

Action = "sts:AssumeRole"

Effect = "Allow"

Principal = {

Service = "datasync.amazonaws.com"

}

}

]

})

}

resource "aws_iam_role_policy" "datasync_s3_access" {

name = "DataSyncS3AccessPolicy"

role = aws_iam_role.datasync_s3_access.id

policy = jsonencode({

Version = "2012-10-17"

Statement = [

{

Effect = "Allow"

Action = [

"s3:GetBucketLocation",

"s3:ListBucket",

"s3:ListBucketMultipartUploads"

]

Resource = [

aws_s3_bucket.source.arn,

aws_s3_bucket.destination.arn

]

},

{

Effect = "Allow"

Action = [

"s3:AbortMultipartUpload",

"s3:DeleteObject",

"s3:GetObject",

"s3:ListMultipartUploadParts",

"s3:PutObject",

"s3:GetObjectTagging",

"s3:PutObjectTagging"

]

Resource = [

"${aws_s3_bucket.source.arn}/*",

"${aws_s3_bucket.destination.arn}/*"

]

}

]

})

}

# 変数定義

variable "environment" {

description = "Environment name"

type = string

default = "production"

}

# S3 バケット(例)

resource "aws_s3_bucket" "source" {

bucket = "datasync-source-bucket-${data.aws_caller_identity.current.account_id}"

}

resource "aws_s3_bucket" "destination" {

bucket = "datasync-destination-bucket-${data.aws_caller_identity.current.account_id}"

}

resource "aws_sns_topic" "alerts" {

name = "datasync-alerts"

}

data "aws_caller_identity" "current" {}

Terraform 実装時の重要なポイント:

- ログレベルの選択:

TRANSFERレベルを使用することで、転送されたすべてのファイルの詳細情報を記録できます。 - ログの保持期間:CloudWatch Logs の保持期間を適切に設定し、コストとコンプライアンス要件のバランスを取ります。

- メトリクスとアラーム:ログデータからメトリクスを抽出し、エラーや異常を自動的に検出するアラームを設定します。

- IAM 権限の最小化:DataSync に必要最小限の権限のみを付与し、セキュリティを強化します。

最後に

この記事では、AWS DataSync タスクでのログ記録を有効にして、データ転送の監視とトラブルシューティングを強化する方法について解説しました。

ログ記録を有効にすることで、データ転送の完全な可視性を確保し、問題の早期発見と迅速な解決が可能になります。特に大規模なデータ移行やミッションクリティカルなデータ同期を行う場合は、ログ記録の有効化は必須です。

この問題の検出は弊社が提供するSecurifyのCSPM機能で簡単に検出及び管理する事が可能です。 運用が非常に楽に出来る製品になっていますので、ぜひ興味がある方はお問い合わせお待ちしております。 最後までお読みいただきありがとうございました。この記事が皆さんの役に立てば幸いです。

CSPMについてはこちらで解説しております。併せてご覧ください。